大黑蚊子 发表于 2025-2-20 03:27

说实话我也在琢磨这个玩意儿,几万块钱搞一个这个玩玩,在AI新浪潮初期真的算是一个比较高性价比的学习途径 ...

马鹿 发表于 2025-2-20 21:45- L/ }8 W* n& @4 z

真心羡慕国内了。。。我90年代自己攒过打游戏的计算机。。。

testjhy 发表于 2025-2-20 09:50- y/ k5 G7 \$ F

社长,美国不是与国内PC价格差不多吗?也仿照沉宝蚊行攒一台呗,

0 \1 L1 k2 x0 b2 F6 J% Q

0 \1 L1 k2 x0 b2 F6 J% Q

testjhy 发表于 2025-2-20 23:323 D! m1 ^ C2 w! x, C8 }7 N

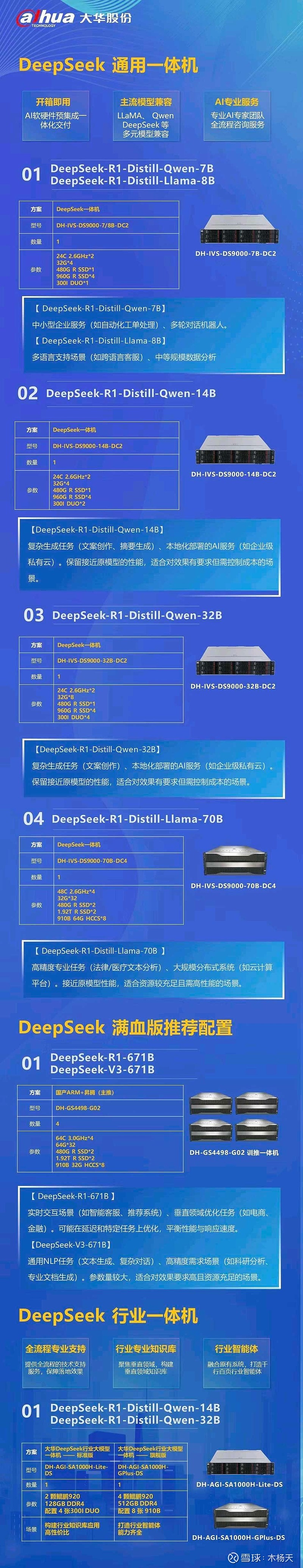

这是大华股份根据国产芯片的一体机,

马鹿 发表于 2025-2-20 23:199 u+ w" [/ T1 r G" _, a

攒了以后干啥呢?

大黑蚊子 发表于 2025-2-20 23:38. _5 ~% k/ s$ B% j! A

大华的这个配置没啥意义,你看跑的都是蒸馏版的7B/14B/32B模型2 l" }+ J. j' X$ L1 U' U* c& v8 q

我在自家电脑上搞了一个7B的模型试了下, ...

testjhy 发表于 2025-2-20 23:45

找了一个非剪裁图,看了一个新闻,华为提供方案,有60多家企业响应,大华可能是比较快的,找不到价格,{: ...

大黑蚊子 发表于 2025-2-20 10:38

大华的这个配置没啥意义,你看跑的都是蒸馏版的7B/14B/32B模型

我在自家电脑上搞了一个7B的模型试了下, ...

马鹿 发表于 2025-2-20 23:53

好奇你攒个模型做啥?

大黑蚊子 发表于 2025-2-20 16:27: j: Y9 u* n5 X2 D) w

说实话我也在琢磨这个玩意儿,几万块钱搞一个这个玩玩,在AI新浪潮初期真的算是一个比较高性价比的学习途径 ...

大黑蚊子 发表于 2025-2-20 23:539 l8 I0 l: |3 O$ x3 r b7 T3 W4 j

我要是鼓捣这玩意儿,肯定是找二手硬件啥的,全新设备的价格那还是相当辣手的

打听了一下Intel的至强4代C ...

大黑蚊子 发表于 2025-2-20 11:03

玩啊,好奇啊,这很可能是通向新世界的大门. L8 J/ q5 Z/ g- J

有这个条件的话,干嘛不玩?

xut6688 发表于 2025-2-21 05:30

在本地部署满血版的DeepSeek R1, 性价比太低了,还不如用各个云厂商的API。 自己学习,玩一玩用云API就好。 ...

沉宝 发表于 2025-2-21 00:16 z/ `. x2 j1 n: w4 i% [7 n4 v

这取决于对问题的理解和取舍。首先在大模型计算中,GPU的能力远远强于CPU,即使那个CPU有amx指令加速。所 ...

大黑蚊子 发表于 2025-2-21 14:10

我建议你再看一下KTransformers的相关资料

这个玩意儿的本质是在低并发(甚至是单并发)的情况下,高度依 ...

沉宝 发表于 2025-2-22 00:10$ e: W6 ~ B3 T

欢迎讨论。, L+ r3 {9 P. @( a; \5 o

首先,个人以为KTransformers的最核心最精华的是抓住了DeepSeek模型参数的稀疏性。DeepSeek ...

大黑蚊子 发表于 2025-3-10 22:257 l, s) X/ l# C X( H/ B M9 E! i

刚刚看到一个案例,有个朋友用2686V4 x2 加256GDDR3跑起了671B的Q2.51版本) j' L n, Q8 f* S/ H# \! j2 s9 s, j+ Y

显卡用的是3070M 16G,环境是U ...

大黑蚊子 发表于 2025-3-10 22:25

刚刚看到一个案例,有个朋友用2686V4 x2 加256GDDR3跑起了671B的Q2.51版本6 m- V/ [3 `& m9 B% P) y" w1 Y

显卡用的是3070M 16G,环境是U ...

数值分析 发表于 2025-3-10 23:42

这里有篇文章是谈万元以下服务器部署DeepSeek-R1 671B + KTransforme的* ?0 g/ W5 p8 F& S9 y5 k( f" z

https://www.pmtemple.com/academy/ ...

大黑蚊子 发表于 2025-3-10 22:25/ `% h9 p3 ]& g

刚刚看到一个案例,有个朋友用2686V4 x2 加256GDDR3跑起了671B的Q2.51版本0 F. X. I8 j) Y3 Y3 k

显卡用的是3070M 16G,环境是U ...

孟词宗 发表于 2025-4-15 10:41" w2 b) d7 S* j- l- R+ r( q. L, a! q

性价比更好的是 HP Z840。这玩意儿有2X Intel Xeon E5-2678 v3 up to 3.1GHz (24 Cores Total),最好的是 ...

nanimarcus 发表于 2025-4-15 12:58- \! r5 G' t! i& e& j8 j

散热的问题,你把机箱敞开,左右两片直接给拆了,开个小风扇对着吹就是了,斜着吹,从前往后,CPU显卡电源 ...

孟词宗 发表于 2025-4-15 14:12) B7 R: U! n) L/ @6 {

同意风冷,但用不着这样 DIY。可以用 联力 LANCOOL 215 https://lian-li.com/product/lancool-215/。这机 ...

nanimarcus 发表于 2025-4-15 17:357 G' y+ O; v$ h1 a3 C1 @0 H

我有点成见,总认为机箱上的风扇不够有力,呵呵。

所以总认为机箱敞开了另外架个风扇吹特别有力,至少视 ...

孟词宗 发表于 2025-4-15 21:456 P" M# ^* R* H9 I# \$ C: ]1 `# B

Caseless 的 DIY 电脑现在也挺多的。散热和灰尘啥的不是问题。

nanimarcus 发表于 2025-4-15 23:26

这个确实很赞。7 t% Z: R4 C, ?+ s( X% {

第一三张好像放不了全尺寸显卡。

孟词宗 发表于 2025-4-15 11:58

没那么贵,Amazon 上一条才 $239。16条也就$3,824。! o( ~! l6 K4 t- E2 ^9 }

https://www.amazon.com/Tech-2666MHz-PC4-21300-Wo ...

雷声 发表于 2025-4-16 07:27& w5 R' a( |+ m8 y7 Z

HP Z系列G4以后支持Intel® Optane™ Persistent Memory,买二手的话更便宜。不过表现怎么样就不好说了。 ...

不过这得看 CPU。如果单个 CPU 只支持 768 GB的话,那两个 CPU 最多也就 1.5 TB。大多数旧的 HP Z8 G4 都最多 1.5 TB。2 N, n7 Y% L9 r9 ?6 J

不过这得看 CPU。如果单个 CPU 只支持 768 GB的话,那两个 CPU 最多也就 1.5 TB。大多数旧的 HP Z8 G4 都最多 1.5 TB。2 N, n7 Y% L9 r9 ?6 J

| 欢迎光临 爱吱声 (http://www.aswetalk.net/bbs/) | Powered by Discuz! X3.2 |